Serverausfall: Risiken, Folgen, Gegenmaßnahmen

Geht es um Kriminalität im Internet, denken Unternehmer in erster Linie an Wirtschaftsspionage, die Entwendung sensibler Geschäftsdaten und eine damit einhergehende Datenschutzverletzung. Doch durch die zunehmende Digitalisierung haben Angriffe aus dem Netz ein neues Ausmaß erreicht. Immer mehr Geschäftsbereiche stützen sich auf IT-Systeme. Diese binden Unternehmen zunehmend an öffentliche Netze an und bieten Hackern somit eine Angriffsfläche. Hat ein Cyberangriff einen Systemausfall zur Folge, kommt es zu kostspieligen Unterbrechungen des Betriebs. Innerhalb weniger Minuten kann ein Serverausfall einen Schaden von mehreren Tausend Euro verursachen. Besonders große Verluste drohen Unternehmen, wenn der Server beispielsweise eine Shop-Software hostet oder zentrale Datenbanken bereitstellt. Doch Serverausfälle haben nicht ausschließlich externe Ursachen. Auch interne Risikoquellen bedrohen den reibungslosen Betriebsablauf.

Neben der Abwehr äußerer Bedrohungen und Standardprozeduren im Rahmen der Disaster-Recovery umfasst ein solides Sicherheitskonzept daher organisatorische und personelle Maßnahmen. Gegenmaßnahmen setzen in der Regel auf Kompensation: Technisch basiert diese darauf, redundante Hardware im Rahmen der Hochverfügbarkeit bereitzustellen oder Ausfallzeiten durch Stand-by-Systeme zu überbrücken. Datensicherheit stellen Administratoren durch Back-up- und Recovery-Software sowie durch redundante Speicherarchitekturen sicher. Die finanziellen Folgen eines Serverausfalls lassen sich durch Versicherungen auffangen.

- Automatisch: Backups und Recovery

- Intuitiv: Planung und Management

- Intelligent: KI-basierter Bedrohungsschutz

- Inkl. 300,- € Startguthaben im 1. Monat

Ausfallszenarien im Überblick

Bei Gefahrenquellen für einen Serverausfall unterscheiden Sicherheitsexperten zwischen internen und externen Bedrohungen. Interne Bedrohungen umfassen alle Szenarien, bei denen Ausfälle durch die eigene IT-Infrastruktur, Versorgungseinrichtungen oder das Fehlverhalten von Mitarbeitern verursacht werden. Bei externen Bedrohungen hingegen handelt es sich um mutwillige Angriffe von außen oder unvorhersehbare Ereignisse wie Unfälle und Katastrophen.

Interne Gefahrenquellen:

- Brand im Rechenzentrum

- Stromausfall im Rechenzentrum

- Hardware-Ausfall (Festplatten-Crash, Überlastung, Überhitzung)

- Softwarefehler (Datenbankenausfall)

- Netzwerkprobleme

- Menschliches Versagen

Externe Gefahrenquellen:

- Infiltration (Man-in-the-Middle-Angriffe, Phishing, Social-Engineering)

- Sabotage (Angriffe auf SCADA-Systeme)

- Viren, Trojaner und Würmer

- Distributed-Denial-of-Service-Angriff (DDoS)

- Diebstahl der Hardware

- Höhere Gewalt (Erdbeben, Blitzschlag, Überschwemmung)

- Unfälle (Flugzeugabsturz)

- Anschläge

In der Regel fällt es Unternehmen leichter, sich auf interne Sicherheitsrisiken vorzubereiten, als auf Bedrohungen von außen. Grund dafür ist, dass Hacker ihre Angriffsmuster stets an aktuelle Sicherheitsstandards anpassen und Firmennetze kontinuierlich mit neuen Schadprogrammen oder Infiltrationsstrategien konfrontieren. Internen Gefahrenquellen hingegen beugen viele Unternehmen hingegen durch eine unterbrechungsfreie Stromversorgung, Brandschutzvorkehrungen, hochverfügbare Server und umfassende Sicherheitsschulungen nachhaltig vor.

Folgen eines Systemausfalls

Ein Serverausfall verursacht finanzielle Schäden. Das ist den meisten Unternehmern klar. Welche Kosten pro Ausfallstunde konkret entstehen, zeigt eine Studie von Techconsult aus dem Jahr 2013. Im Auftrag von HP Deutschland untersuchte das Marktforschungsunternehmen deutschlandweit 300 mittelständische Unternehmen mit 200 bis 4.999 Mitarbeitern. Rund 77 Prozent der befragten Mittelständer verzeichneten im Vorjahr der Studie Ausfälle geschäftskritischer IT-Systeme. Betroffen waren unter anderem Warenwirtschaft, Fertigung und Vertrieb. Im Durchschnitt kam es im Untersuchungszeitraum zu vier Ausfällen pro Unternehmen. Die durchschnittliche Zeit für Ausfallbehebung und Daten-Wiederherstellung betrug 3,8 Stunden.

Welche Kosten pro Ausfallstunde entstanden, variiert je nach Unternehmensgröße. Während Unternehmen mit weniger als 500 Mitarbeitern Schäden von rund 20.000 Euro pro Stunde verzeichneten, betrugen die Kosten pro Ausfallstunde bei Unternehmen mit mehr als 1000 Mitarbeitern rund 40.000 Euro. Im Durchschnitt schlägt ein Ausfall von IT-Systemen bei Mittelständlern mit rund 25.000 Euro pro Ausfallstunde zu Buche. Rechnet man die Zeit für die Ausfallbehebung und Datenwiederherstellung mit ein, gehen dem deutschen Mittelstand pro Unternehmen jährlich 380.000 Euro durch Serverausfälle verloren.

Ob und in welchem Umfang es in einem Unternehmen durch einen Serverausfall zur Betriebsunterbrechung kommt, hängt jedoch stark mit der jeweiligen Branche und dem Geschäftsmodell zusammen. Prinzipiell ist es Mitarbeitern durchaus möglich, auf alternative Tätigkeiten auszuweichen, indem sie beispielsweise Meetings einberufen, Telefonate führen oder Kundentermine vorverlegen. Doch wenn zentrale Prozesse nicht nur IT-gestützt, sondern komplett von IT-gesteuert werden, ist eine Downtime besonders einschneidend. Teuer wird es beispielsweise, wenn ein Onlineshop offline ist und Kunden keine Bestellungen mehr aufgeben können oder ein Ausfall des SCADA-Systems die Produktion lahmlegt.

Die Kostenkalkulation einer Betriebsunterbrechung sollte neben dem Stundensatz von Mitarbeitern, die zur Untätigkeit gezwungen sind, in jedem Fall auch Verluste durch ausbleibende Kundenaufträge oder Bestellungen sowie mögliche Vertragstrafen durch Lieferungsverzug berücksichtigen. Hinzu kommt der nur schwer zu quantifizierende Schaden des Imageverlusts durch verärgerte Kunden.

Gegenmaßnahmen

Um Serverausfällen entgegenzuwirken, gilt es, reellen Risiken durch Präventionsmaßnahmen vorzubeugen. Diese beziehen sich in der Regel auf eine Reihe infrastruktureller und organisatorischer Maßnahmen bei der Auswahl und Gestaltung des Serverraums. Eine Sammlung entsprechender Sicherheitsmaßnahmen bietet das IT-Grundschutz-Kompendium des Bundesamts für Sicherheit in der Informationstechnik (BSI).

Brandschutz und Versorgungseinrichtungen

Um Serverausfällen durch physische Einflüsse wie Brände, Hochwasser, Stromausfall oder Hardwaresabotage vorzubeugen, müssen Serverräume und Rechenzentren entsprechend eingerichtet sein. Dies beginnt bereits mit der Standpunktwahl. Nicht zu empfehlen sind Kellerräume, bei denen die Gefahr besteht, dass diese bei Unwetter oder Naturkatastrophen mit Regenwasser volllaufen. Zudem sollte der Zugang zu den Räumlichkeiten auf Fachpersonal beschränkt und unter Umständen durch Sicherheitsschleusen kontrolliert werden. Serverräume sind nicht als dauerhafte Arbeitsplätze gedacht.

Schäden durch Brände lassen sich durch Brandschutz- und Löschsysteme kompensieren. Diese umfassen die Installation von Brandschutztüren, Brandmeldeeinrichtungen, Handfeuerlöschern und automatischen Löschsystemen (z. B. Gaslöschanlagen). Weitere vorbeugende Maßnahmen sind Brandschutzvorgaben zur sachgerechten Lagerung von brennbaren Materialien, Brandabschottungen auf Kabeltrassen und die Verwendung geeigneter Dämmmaterialien zur Wärme- oder Schallisolierung.

Technische Geräte setzen elektrische Energie in Wärme um. Ein zusätzlicher Temperaturanstieg im Serverraum kann durch Sonneneinstrahlung erfolgen. Um Serverausfällen und Datenfehlern aufgrund von Überhitzung und zu hoher Luftfeuchtigkeit entgegenzuwirken, sollten leistungsstarke Lüftungsanlagen und Kühlsysteme zum Einsatz kommen. Die optimalen Lagerbedingungen für Langzeitspeichermedien werden laut BSI bei Temperaturen von 20 bis 22°C und einer Luftfeuchtigkeit von 40 Prozent erreicht.

Grundvoraussetzung für einen reibungslosen Serverbetrieb ist zudem eine konstante Stromversorgung. Störungen im IT-Betrieb sind laut BSI schon bei Unterbrechungen von mehr als 10 ms möglich. Überbrücken lassen sich Versorgungslücken und längere Ausfälle durch Notstromgeneratoren. Diese ermöglichen zeitweise einen autarken Betrieb unabhängig vom öffentlichen Stromnetz und helfen so, einer Betriebsunterbrechung entgegenzuwirken.

Ausfallsicherheit

Vor allem Mittelständler unterschätzen die Auswirkungen von IT-Ausfällen auf den Geschäftsbetrieb. Ein Grund dafür ist die hohe Zuverlässigkeit von Standardkomponenten, die heutzutage in der Unternehmens-IT zum Einsatz kommen. Deren Verfügbarkeit wird in der Regel auf 99,9 Prozent geschätzt. Ein Wert, der hoch erscheint, bei einem 24-Stundenbetrieb aufs Jahr gerechnet aber eine maximale Ausfallzeit von fast 9 Stunden zulässt. Fällt diese ausgerechnet in die Hauptgeschäftszeit, kommt auch ein relativ kurzer Serverausfall dem Unternehmen teuer zu stehen. Für die Bereitstellung geschäftskritischer Daten und Anwendungen haben sich daher hochverfügbare IT-Systeme mit einer Verfügbarkeit von 99,99 Prozent als Standard etabliert. Für diese wird eine maximale Downtime von 52 Minuten pro Jahr garantiert. Einige IT-Experten sprechen sogar erst ab einer Verfügbarkeit von 99,999 Prozent von Hochverfügbarkeit. Diese Systeme fallen dann maximal 5 Minuten im Jahr aus. Das Problem an solchen Verfügbarkeitsangaben ist jedoch, dass diese sich lediglich auf die Ausfallsicherheit der Serverhardware beziehen. Der Definition des IEEE (Institute of Electrical and Electronics Engineers) zufolge gilt ein System als hochverfügbar, wenn es trotz des Ausfalls von Systemkomponenten die Verfügbarkeit seiner IT-Ressourcen sicherstellen kann: „High Availability (HA for short) refers to the availability of resources in a computer system, in the wake of component failures in the system.” Erreicht wird dies beispielsweise durch Server, die komplett redundant aufgebaut sind. Alle betriebswichtigen Bauteile – insbesondere Prozessoren, Speicher-Chips und I/O-Einheiten – sind doppelt vorhanden. Dies verhindert zwar zuverlässig, dass ein defektes Bauteil den Server lahmlegt, doch gegen einen Brand im Rechenzentrum, zielgerichtete Angriffe durch Schadsoftware und DDoS-Attacken, Sabotage oder die Übernahme des Servers durch Hacker schützt Hochverfügbarkeit hingegen nicht. Im realen Betrieb sollten Unternehmer daher mit deutlich längeren Ausfallzeiten rechnen und entsprechende Maßnahmen zu Prävention und Schadensbegrenzung treffen. Weitere Strategien, den Ausfall von Serverressourcen im Rechenzentrum zu kompensieren, beruhen auf Stand-by-Systemen und Hochverfügbarkeitsclustern. Beide Ansätze basieren auf einem Verbund von zwei oder mehr Servern, die gemeinsam mehr Hardware-Ressourcen zur Verfügung stellen, als für den Normalbetrieb benötigt werden. Bei einem Stand-by-System handelt es sich um einen zweiten Server, der der Absicherung des Primärsystems dient und dessen Dienste übernimmt, sobald selbiger aufgrund eines Hard- oder Softwarefehlers ausfällt. Die Dienstübernahme wird Failover genannt und durch eine Cluster-Manager-Software automatisch ohne Eingriff des Administrators eingeleitet. Ein solcher Aufbau aus einem aktiven und einem passiven Serverknoten kann als asymmetrisches Hochverfügbarkeitscluster betrachtet werden. Bieten alle Knoten im Cluster im Normalbetrieb Dienste an, spricht man von einem symmetrischen Aufbau. Da es bei der Migration eines Dienstes von einem System auf ein anderes zu einer Zeitverzögerung kommt, lassen sich kurzzeitige Betriebsunterbrechung bei Stand-by-Systemen und Hochverfügbarkeitsclustern nicht gänzlich verhindern.

Abwehrsysteme

Dem schädlichen Einfluss durch Hacker setzen Administratoren verschiedene Software- und Hardware-Lösungen entgegen, die Angriffe entdecken, abwehren, aufzeichnen und umlenken sollen. Um einen Server gegen unerlaubte Zugriffe zu schützen, werden kritische Systeme mit Firewalls und Demilitarisierten Zonen (DMZ) von öffentlichen Netzwerken abgeschottet.

Angriffserkennungssysteme, sogenannte Intrusion Detection Systems (IDS), ermöglichen ein automatisches Monitoring von Servern und Netzwerken und schlagen Alarm, sobald manuelle Einbruchsversuche oder automatisierte Attacken durch Schadsoftware registriert werden: Ein Vorgang, der auf Mustererkennung und statistischen Analysen basiert. Kommen Intrusion Prevention Systems (IPS) zum Einsatz, folgen dem Alarm automatisierte Gegenmaßnahmen. Üblich ist eine Anbindung an die Firewall, wodurch Datenpakete verworfen oder verdächtige Verbindungen unterbrochen werden können.

Um Hacker von geschäftskritischen IT-Systemen fernzuhalten, bedienen sich Administratoren zudem sogenannter Honeypots. Diese erscheinen Angreifern als vermeintlich attraktive Ziele, laufen isoliert vom Produktivsystem und haben somit keinen Einfluss auf dessen Funktionalität. Honeypots werden konstant überwacht und ermöglichen, zeitnah auf Einbrüche zu reagieren und die verwendeten Angriffsmuster und Strategien zu analysieren.

Datensicherung und Recovery

Um geschäftskritische Daten auch im Fall eines Serverausfalls schnell wiederherstellen zu können, empfiehlt das BSI die Ausarbeitung eines Datensicherungskonzepts gemäß internationaler Industriestandards wie ISO 27001. Dieses regelt, wer für die Datensicherung zuständig ist, und benennt Entscheidungsträger, die eine Datenwiederherstellung veranlassen können. Weiterhin legt das Datensicherungskonzept fest, wann Back-ups erstellt werden müssen, wie viele Generationen gespeichert werden, welches Speichermedium zum Einsatz kommt und ob spezielle Transportmodalitäten wie eine Verschlüsselung erforderlich sind. Darüber hinaus wird die Art der Datensicherung definiert:

- Volldatensicherung: Werden sämtliche zu sichernden Daten zu einer bestimmten Zeit auf einem zusätzlichen Speichersystem abgelegt, spricht man von einer Volldatensicherung. Ob sich die Daten seit dem letzten Speichervorgang geändert haben, wird bei solchen Back-ups nicht berücksichtigt. Eine Volldatenspeicherung nimmt daher viel Zeit in Anspruch und hat einen hohen Speicherbedarf, der vor allem dann ins Gewicht fällt, wenn mehrere Generationen parallel aufbewahrt werden. Diese Art der Datensicherung punktet jedoch durch eine einfache und schnelle Datenwiederherstellung, da lediglich der letzte Speicherstand rekonstruiert werden muss. Diesen Vorteil verspielen Unternehmen jedoch, wenn Back-ups zu selten durchgeführt werden. In einem solchen Fall entsteht ein hoher Arbeitsaufwand, um nachträglich geänderte Dateien an den aktuellen Stand anzupassen.

- Inkrementelle Datensicherung: Entscheiden sich Unternehmen für eine inkrementelle Datensicherung, umfasst das Back-up nur die Dateien, die sich seit der letzten Datensicherung geändert haben. Damit verringert sich nicht nur die Zeit, die benötigt wird, um ein Back-up durchzuführen. Auch der Speicherbedarf für verschiedene Generation ist deutlich geringer als bei der Volldatenspeicherung. Eine inkrementelle Datensicherung setzt mindestens ein durch Volldatensicherung erzeugtes Back-up voraus. In der Praxis kommt es daher oft zu Kombinationen beider Speicherstrategien. Dabei werden mehrere inkrementelle Back-ups zwischen zwei Volldatensicherungen erzeugt. Bei einer Datenwiederherstellung wird die letzte Volldatensicherung als Grundlage genommen und um die Daten aus den inkrementellen Speicherzyklen ergänzt. In der Regel müssen dabei mehrere Datensicherungen nacheinander abgeglichen werden.

- Differenzielle Datensicherung: Auch die differenzielle Datensicherung baut auf der Volldatensicherung auf. Dabei werden alle Daten gesichert, die sich seit der letzten Volldatensicherung geändert haben. Anders als bei der inkrementellen Datensicherung findet dabei keine Verkettung mehrere Back-ups statt. Für eine Datenwiederherstellung genügt daher ein Abgleich der letzten Volldatensicherung mit dem aktuellsten differenziellen Back-up.

Welche Speicherstrategie im Unternehmen zum Einsatz kommt, richtet sich nach den jeweiligen Verfügbarkeitsanforderungen sowie nach wirtschaftlichen Gesichtspunkten. Zentrale Einflussfaktoren sind tolerierbare Wiederherstellungszeiten, Häufigkeit und Zeitpunkt der Datensicherung sowie das Verhältnis zwischen Änderungsvolumen und Gesamtdatenvolumen. Sind Letztere nahezu deckungsgleich, ist eine Speicherersparnis durch inkrementelle oder differenzielle Verfahren vernachlässigbar.

Schulungen

Maßnahmen zur Informationssicherheit lassen sich unternehmensweit nur etablieren, wenn alle Mitarbeiter erkennen und akzeptieren, dass selbige einen wesentlichen Anteil am wirtschaftlichen Erfolg des Unternehmens hat. Aufbauen und pflegen lässt sich ein solches Sicherheitsbewusstsein durch regelmäßige Schulungen, die Mitarbeiter für interne und externe Gefahrenquellen sensibilisieren, Risikoszenarien durchspielen und mögliche Folgen aufzeigen.

Die Basis systematischer Schulungen sind Regelungen und Vorschriften zum Umgang mit sicherheitsrelevanten Geräten und Einrichtungen sowie ein Notfallkonzept, das Mitarbeitern Handlungsanweisungen bietet, welche Schritte einzuleiten sind, um den Normalbetrieb schnellstmöglich wiederherzustellen. Eine strukturierte Herangehensweise an die Erstellung entsprechender Konzepte bietet das Business-Continuity-Management.

Business-Continuity-Management (BMC)

Um den Schaden durch Serverausfälle möglichst gering zu halten, investieren Unternehmen zunehmend in Präventionsmaßnahmen. Im Fokus steht dabei das sogenannte Business-Continuity-Management (BMC). Im IT-Bereich zielen BMC-Strategien darauf ab, einem Serverausfall in geschäftskritischen Bereichen entgegenzuwirken und im Falle einer Unterbrechung eine unverzügliche Wiederaufnahme sicherzustellen. Voraussetzung für ein entsprechendes Notfallmanagement ist eine sogenannte Business-Impact-Analyse (BIA). Eine solche hilft Unternehmen, kritische Geschäftsprozesse zu identifizieren. Als kritisch wird ein Prozess dann bezeichnet, wenn ein Ausfall signifikante Auswirkungen auf den Betrieb hat. Die BIA konzentriert sich dabei zunächst auf die Konsequenzen konkreter Schadensszenarien. Ursachen für einen Serverausfall, die Eintrittswahrscheinlichkeit möglicher Gefährdungen und Gegenmaßnahmen werden im Rahmen der Risikoanalyse erfasst.

Wie sich BIA und Risikoanalyse im Rahmen der BMC methodisch umsetzen lassen, ist Inhalt diverser Standards und Rahmenwerke. Als anschaulicher Leitfaden empfiehlt sich beispielsweise der Grundschutz-Standard 100-4 „Notfallmanagement“ des Bundesamts für Sicherheit in der Informationstechnik.

Business-Impact-Analyse (BIA)

Der erste Schritt auf dem Weg zu einem umfassenden Business-Continuity-Management ist die Business-Impact-Analyse, die im Deutschen auch Folgeschadenabschätzung oder Betriebsunterbrechungsanalyse genannt wird. Zentrale Fragen im Rahmen dieser Analyse sind: Welche Systeme sind von zentraler Bedeutung, um das Kerngeschäft aufrechtzuerhalten? Und welche Folgen hat ein Ausfall dieser Systeme auf den Betrieb? Dabei empfiehlt es sich, die wichtigsten Produkte und Dienstleistungen eines Unternehmens sowie deren zugrundeliegende IT-Infrastruktur zu identifizieren. Setzt ein Unternehmen in erster Linie auf den Verkauf im Internet, sind die Server, die den Onlineshop und zugehörige Datenbanken bereitstellen, besonders schützenswert. Ein Callcenter hingegen wird die technische Grundlage der Telefonanlage als geschäftskritisch klassifizieren. Die BIA beinhaltet eine Priorisierung der zu schützenden Systeme, eine Schadenskalkulation sowie eine Erhebung der benötigten Ressourcen für einen Wiederanlauf der Systeme.

Risikoanalyse

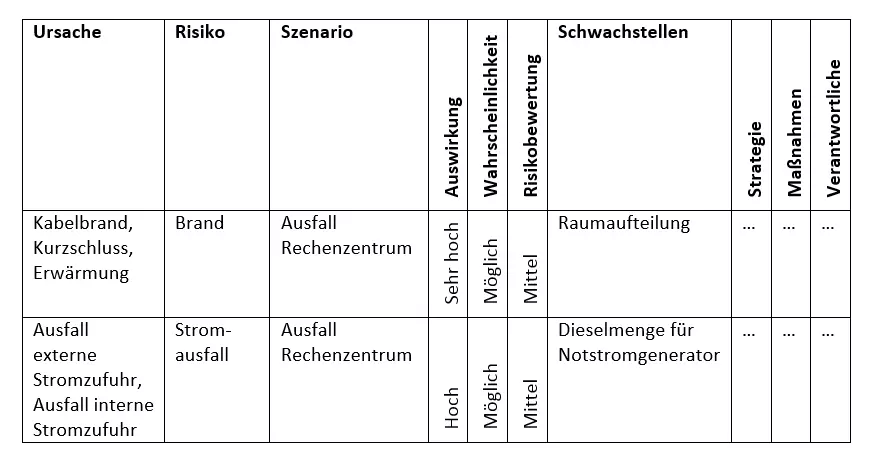

Eine Risikoanalyse hat im Rahmen des Notfallmanagements die Funktion, interne und externe Gefahrenquellen zu identifizieren, die einen Serverausfall und eine damit verbundene Betriebsunterbrechung verursachen könnten. Ziel ist es, die Sicherheitsrisiken und deren Ursachen transparent zu machen und adäquate Gegenmaßnahmen zu entwickeln, um das erkannte Gefahrenpotenzial zu reduzieren. Eine Bewertung der Risiken lässt sich anhand des erwarteten Schadens und der Eintrittswahrscheinlichkeit vornehmen. Ein Beispiel für eine Risikoklassifikation zeigt folgendes Beispiel aus dem BSI-Standard 100-4:

Erfassung des Ist-Zustands

Wurden die Gefahrenquellen und das Schadenspotenzial konkreter Serverausfall-Szenarien im Rahmen der BIA und der Risikoanalyse ermittelt, folgt im dritten Schritt auf dem Weg zur Kontinuitätsstrategie eine Erfassung des Ist-Zustands. Von Bedeutung sind dabei bereits etablierte Notfallvorsorgemaßnahmen sowie aktuelle Wiederanlaufzeiten. Die Erfassung des Ist-Zustands ermöglicht Unternehmen, einen Handlungsbedarf bei konkreten Sicherheitsrisiken sowie damit verbundene Investitionskosten abzuschätzen.

Auswahl der Kontinuitätsstrategie

In der Regel gibt es für die verschiedenen internen und externen Gefahrenquellen diverse Strategien, die eine Fortführung des Betriebs trotz Störung oder eine schnelle Wiederanlaufzeit versprechen. Im Rahmen des Business-Continuity-Managements ist es daher Aufgabe der Entscheidungsträger, abzuwägen, welche Kontinuitätsstrategie im Ernstfall zur Anwendung kommen soll. Grundlage dieser Entscheidung ist eine Kosten-Nutzen-Analyse, die zentrale Faktoren wie die benötigten finanziellen Mittel, die Zuverlässigkeit der Lösung oder die geschätzte Wiederanlaufzeit beinhaltet.

Soll beispielsweise eine Kontinuitätsstrategie entwickelt werden, die einem Brand im Rechenzentrum vorbeugt, stehen verschiedene Lösungswege zur Auswahl: Minimale Lösungen umfassen die Schadenskompensation durch eine Betriebsausfallversicherung und ein Ausweichrechenzentrum bei einem Hosting-Dienstleister. Kostspieliger hingegen wäre der Umbau des bestehenden Serverraums nach modernen Brandschutzstandards. Sind größere Investitionen möglich, lassen sich Folgeschäden durch den Bau eines zweiten, redundanten Serverraums reduzieren.

Ausgearbeitete Kontinuitätsstrategien werden im Notfallsicherheitskonzept festgehalten, das konkrete Handlungsanweisungen für alle relevanten Notfallszenarien enthält.